Auto-Encoding Variational Bayes

논문 원본 : https://arxiv.org/abs/1312.6114

Auto-Encoding Variational Bayes

How can we perform efficient inference and learning in directed probabilistic models, in the presence of continuous latent variables with intractable posterior distributions, and large datasets? We introduce a stochastic variational inference and learning

arxiv.org

1. Abstract & Introduction

- "intractable한 사후 확률분포를 가진 연속적인 latent variable와 큰 데이터 셋이 있을 때, directed probabilistic models (방향성 확률 모델)에서 효율적인 추론과 학습을 수행하려면 어떻게 해야 될까?"

SGVB (Stochastic Gradient Variational Bayes) estimator

- variational lower bound의 reparameterization을 통한 lower bound estimator

- 연속형 latent variables와 parameter를 가지는 모델에서도 효율적인 approximate posterior inference 수행

AEVB (Auto-Encoding Variational Bayesian) algorithm

- 연속형 latent variables를 가지는 i.i.d 데이터셋인 경우

- SGVB estimator를 사용하여 approximate inference model(또는 recognition model)을 intractable한 posterior에 fitting

- 이와 같은 효율적인 posterior inference을 통해 MCMC와 같이 계산량이 많은 추론 방법을 사용할 필요가 없어짐

2. Method

2.1 Problem scenario

- 분석하려는 데이터셋은 i.i.d.(독립적이고 동일한 분포를 따르는 데이터셋)이라고 가정

- 즉, 데이터 포인트들이 서로 독립적이고 같은 방식으로 생성됨 (연속 또는 이산 변수 x)

- 본 논문은 이 데이터가 관측되지 않은 continuous latent variable z를 포함하는 어떤 확률적 과정에 의해 생성된다고 가정. 그 과정은 크게 두 가지 단계로 이루어짐

- 1) 먼저, 어떤 사전 확룰 분포 로부터 가 샘플링됨

- 2) 이후, 조건부 확룰 분포 를 통해 가 생성

- 목표는 아래의 Data Likelihood를 최대화하는 것

- But, p(x|z)를 z에 대해 적분할 수 없음 (Intractable)

- z는 고차원 벡터

- 고차원 적분은 계산량이 기하급수적으로 증가 (불가능에 가까움)

- 이를 위해 확률적 encoder qθ(z|x)를 만들어 냄

- = intractable true posterior인 pθ(z|x)에 대한 approximation

- 즉, decoder만 있는 형태에서 encoder를 만들어서 intractable 했던 likelihood를 tractable하게 만듦

2.2 The variational bound

- 사전 지식

- Loss function 정의

- log pθ(x(i))를 최대화하는 게 목표

- ELBO를 이용한 Loss Function

- Reconstruction Error : xi에 대한 복원 오차

- Regularization : x가 q를 통과하여 나온 z의 distribution과 사전에 가정한 z의 distribution이 일치하도록 만듦

2.3 THE SGVG estimator and AEVB algorithm

Assumptions

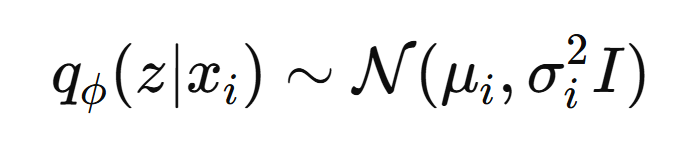

- Recognition Model (Posterior Approximation) & Prior Distribution

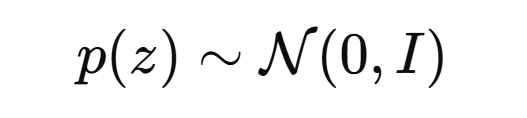

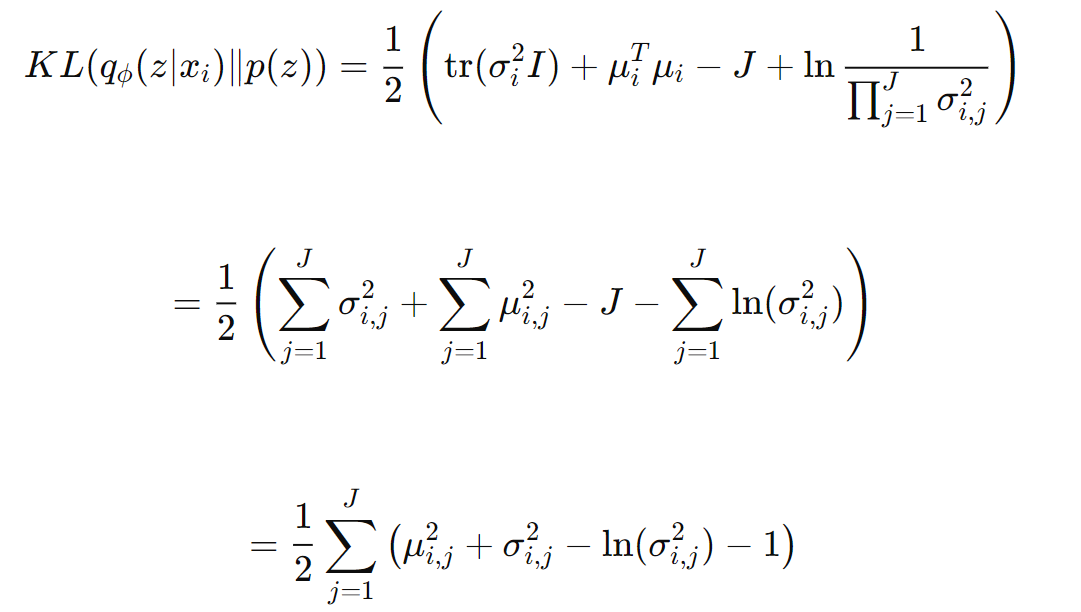

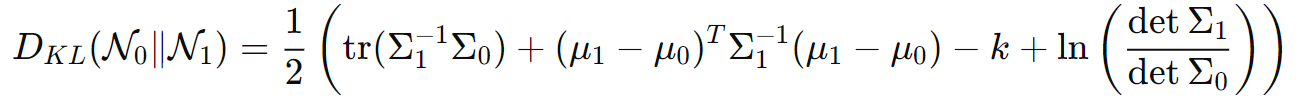

Regularization 계산

- KLD for multivariate normal distributions

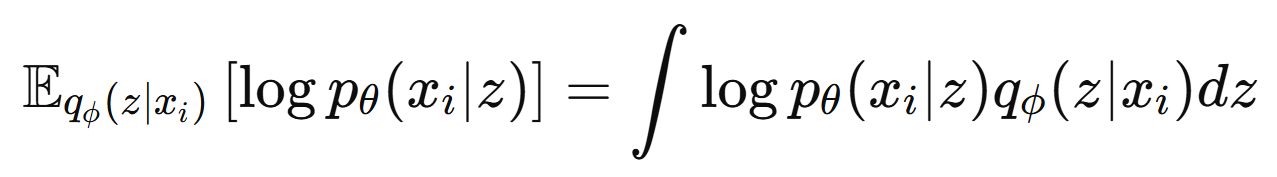

Reconstruction Error 계산

- 적분 난이도 큼

- Monte-carlo 활용

- 단, L=1로 설정 (trick)

- 즉, 샘플링 한 번만 수행

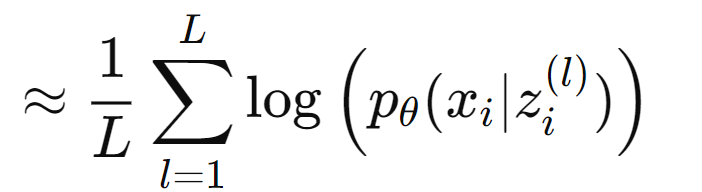

- 분포 가정 1 (bernoulli)

- cross entropy로 변환 가능

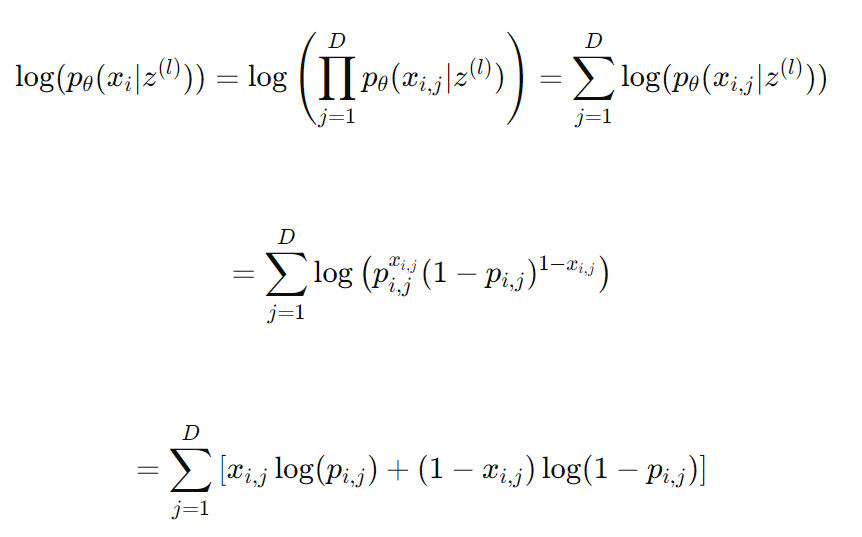

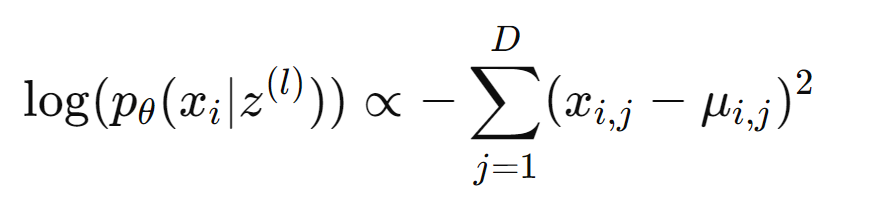

- 분포 가정 2 (gaussain)

- squared error로 변환 가능

2.4 The reparameterization trick

- 평균 0, 표준편차 1인 정규분포를 만들어 ε 를 뽑음

- ε를 σ 에 곱해주고 이를 μ 에 더해줘 미분 가능한 식을 만들어줌

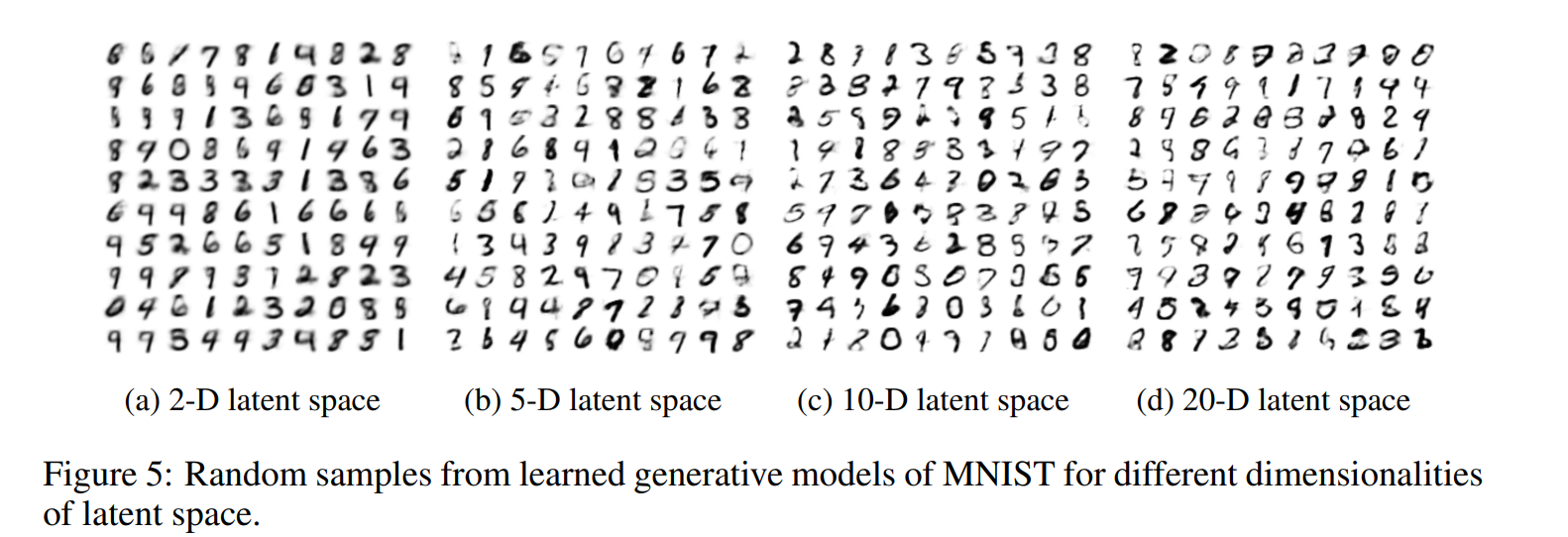

3. Experiments

- latent variables 차원에 따른 성능 변화

4. Conclusion

- 본 논문에서는 SGVB estimator를 도입하여 continuous latent variables를 사용하는 효율적인 근사 추론 방법을 제안

- SGVB (Stochastic Gradient Variational Bayes)

- 변분 하한(ELBO)의 새로운 추정 방법

- Stochastic Gradient 최적화가 가능하도록 설계됨

- 기존 방법보다 효율적으로 미분 및 최적화 가능

- AEVB (Auto-Encoding Variational Bayes) 알고리즘

- 독립적인 데이터(i.i.d.) 및 연속 잠재 변수를 다루는 효율적인 학습 알고리즘

- SGVB 추정기를 활용하여 근사 추론 모델을 학습

- VAE의 기반이 되는 기법

- SGVB (Stochastic Gradient Variational Bayes)

5. Reference

https://www.youtube.com/watch?v=GbCAwVVKaHY

'논문 리뷰 > CV' 카테고리의 다른 글

| [X:AI] BYOL 논문 리뷰 (0) | 2024.08.05 |

|---|---|

| [X:AI] NeRF 논문 리뷰 (0) | 2024.07.28 |

| [X:AI] Detr 논문 리뷰 (1) | 2024.07.23 |

| [X:AI] MOFA-Video 논문 리뷰 (0) | 2024.07.20 |

| [D&A] GAN 논문 리뷰 (1) | 2024.07.17 |